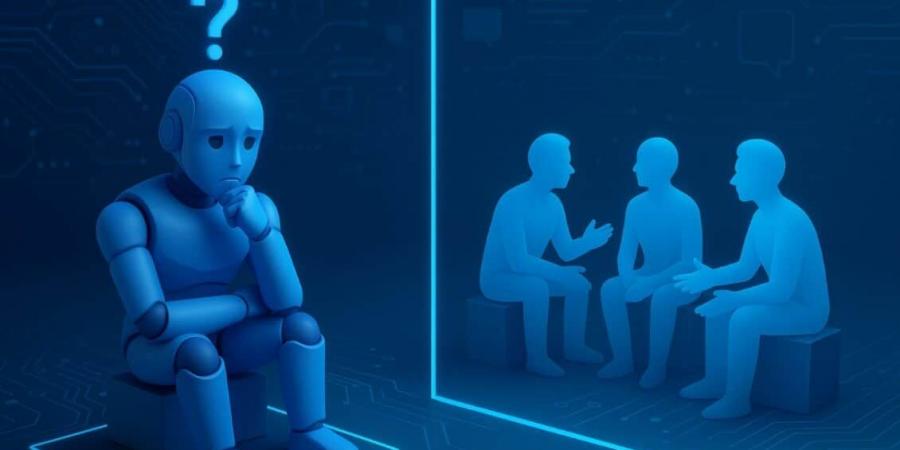

نقدم لكم زوارنا الكرام أهم وآخر المستجدات كما وردت في المقال التالي: دراسة تكشف ضعف الذكاء الاصطناعي في فهم التفاعلات الاجتماعية اليوم الأربعاء 7 مايو 2025 09:39 مساءً

كشفت دراسة حديثة أجراها باحثون في جامعة جونز هوبكينز (Johns Hopkins University) أن البشر يتفوقون على نماذج الذكاء الاصطناعي الحالية في وصف التفاعلات الاجتماعية وتفسيرها ضمن مشاهد ديناميكية. وتُعد هذه القدرة ضرورية لتطوير السيارات الذاتية القيادة والروبوتات المساعدة التي تعتمد بنحو أساسي على الذكاء الاصطناعي للتنقل الآمن في البيئات الحقيقية.

تُبرز الدراسة أن أنظمة الذكاء الاصطناعي الحالية تعاني مشكلة في فهم التفاعلات الاجتماعية الدقيقة والإشارات السياقية الأساسية للتفاعل الفعّال مع البشر. وتشير النتائج إلى أن هذا القصور قد يكون سببه طبيعة البُنية الأساسية لنماذج الذكاء الاصطناعي الحالية.

عُرضت نتائج الدراسة في مؤتمر (International Conference on Learning Representations) للتعلم الآلي والذكاء الاصطناعي في 24 أبريل. وقد قالت (Leyla Isik)، المؤلفة الرئيسية للدراسة و الأستاذة المساعدة في قسم علوم الإدراك في جامعة جونز هوبكينز: “على سبيل المثال: نظام الذكاء الاصطناعي في السيارات الذاتية القيادة، يحتاج إلى تعرّف نوايا وأهداف وتصرفات السائقين والمشاة من البشر. نريد منه أن يعرف في أي اتجاه سيبدأ أحد المشاة بالسير، أو كون شخصين يتحدثان معًا أم على وشك عبور الشارع. وفي أي وقت نريد فيه أن يتفاعل الذكاء الاصطناعي مع البشر بنحو مباشر، نحتاج منه أن يفهم ما يقوم به الناس. وهذه الدراسة تسلط الضوء على أن أنظمة الذكاء الاصطناعي الحالية غير قادرة على ذلك حتى الآن”.

تفاصيل الدراسة

للمقارنة بين أداء نماذج الذكاء الاصطناعي والبشر في فهم التفاعلات الاجتماعية، طُلب من مشاركين بشريين مشاهدة مقاطع فيديو قصيرة مدتها ثلاث ثوانٍ، وتقييم سمات مهمة لفهم التفاعلات الاجتماعية، وشملت المقاطع مشاهد لأشخاص إما يتفاعلون مع بعضهم بنحو مباشر، أو يقومون بأنشطة تعاونية، أو ينفذون أنشطة مستقلة.

بعد ذلك، طُلب من أكثر من 350 نموذجًا للذكاء الاصطناعي – تضمن ذلك نماذج لغوية ونماذج تدربت على مقاطع فيديو وأخرى تدربت على صور ثابتة – التنبؤ بكيفية تقييم البشر للمقاطع، وكيف ستكون استجابات أدمغتهم عند المشاهدة.

قدّم المشاركون البشريون إجابات متقاربة، ولم تتمكن نماذج الذكاء الاصطناعي من بلوغ مستوى الدقة نفسه بغض النظر عن حجمها أو نوعية البيانات التي تدربت عليها. فلم تتمكن النماذج المدربة باستخدام مقاطع فيديو من وصف ما يفعله الأشخاص بدقة، وحتى النماذج المعتمدة على الصور الثابتة لم تستطع فهم أن بعض الأشخاص الذين يظهرون في مقاطع الفيديو يتواصلون معًا. وأما النماذج اللغوية فقد أظهرت أداء أفضل في التنبؤ بالسلوك البشري.

فجوة في تطوير الذكاء الاصطناعي

قال الباحثون إن النتائج تُظهر تباينًا كبيرًا مع نجاح الذكاء الاصطناعي في تفسير الصور الثابتة. وقالت Kathy Garcia، طالبة الدكتوراه وإحدى مؤلفات الدراسة: “رؤية صورة وتعرف الوجوه والأشياء لم يعد أمرًا كافيًا. كانت تلك خطوة أولى لتطوير أنظمة الذكاء الاصطناعي، ولكن الحياة الواقعية ليست ثابتة. نحن بحاجة إلى أن يفهم الذكاء الاصطناعي العلاقات والسياق وديناميكيات التفاعلات الاجتماعية، وتشير هذه الدراسة إلى أن هناك فجوة في تطوير النماذج الحالية”.

ويعتقد الباحثون أن سبب هذه الفجوة هو أن الشبكات العصبية للذكاء الاصطناعي استُلهمت من البنية الدماغية المسؤولة عن معالجة الصور الثابتة، وهي مختلفة عن المناطق الدماغية التي تتعامل مع المشاهد الاجتماعية الديناميكية.

وقالت (Leyla Isik): “هناك الكثير من التفاصيل الدقيقة التي يمكن استخلاصها من نتائج الدراسة، لكن الاستنتاج المهم هو أن جميع نماذج الذكاء الاصطناعي المتوفرة حاليًا لا يمكنها مطابقة استجابات الدماغ والسلوك البشري للمشاهد الديناميكية، كما تفعل تلك النماذج مع الصور الثابتة. وأعتقد أن هناك شيئًا أساسيًا في الطريقة التي يعالج بها الإنسان المشاهد تفتقر إليه هذه النماذج”.

نشكركم على القراءة، ونتطلع لمشاركتكم في مقالاتنا القادمة للحصول على أحدث الأخبار والمستجدات.

0 تعليق